LA PROMOTION DU RACISME SCIENTIFIQUE DANS LES RÉSULTATS DE RECHERCHE PAR GOOGLE, MICROSOFT ET PERPLEXITY

LE PROBLÈME DES AI OVERVIEWS DANS LES RÉSULTATS DE RECHERCHE

Selon Google, l’un des défis rencontrés dans la génération des AI Overviews est le manque d’informations de haute qualité sur le web pour certaines requêtes très spécifiques. Cependant, il est indéniable que le travail de Lynn ne relève pas de cette haute qualité. En effet, selon Sear, la science sous-jacente à la base de données de QI nationaux de Lynn est de si mauvaise qualité qu’il est difficile de croire que la base de données soit autre chose que frauduleuse. Lynn n’a jamais décrit sa méthodologie de sélection des échantillons dans la base de données, et de nombreux pays ont des QI estimés à partir d’échantillons absurdes et non représentatifs.

PROBLÈMES DE MÉTHODOLOGIE ET DE QUALITÉ DES ÉCHANTILLONS

Sear souligne que l’estimation du QI de l’Angola par Lynn repose sur des informations provenant de seulement 19 personnes, tandis que celle de l’Érythrée est basée sur des échantillons d’enfants vivant dans des orphelinats. Rutherford ajoute que les données utilisées par Lynn pour générer ce jeu de données sont tout simplement absurdes, avec des exemples tels que le chiffre somalien dans le jeu de données de Lynn basé sur un seul échantillon de réfugiés âgés de 8 à 18 ans testés dans un camp de réfugiés kényan. Il mentionne également que le score du Botswana est basé sur un seul échantillon de 104 élèves du secondaire parlant la langue tswana, âgés de 7 à 20 ans, testés en anglais.

CRITIQUES DES TESTS DE QI NATIONAUX

Les critiques de l’utilisation des tests de QI nationaux pour promouvoir l’idée de la supériorité raciale soulignent non seulement que la qualité des échantillons collectés est faible, mais aussi que les tests eux-mêmes sont généralement conçus pour un public occidental, ce qui les biaise avant même leur administration. Sears affirme qu’il existe des preuves indiquant que Lynn a systématiquement biaisé la base de données en incluant de manière préférentielle des échantillons avec des QI bas, tout en excluant ceux avec des QI plus élevés pour les nations africaines, une conclusion étayée par une étude préliminaire de 2020.

L’UTILISATION INCORRECTE DES DONNÉES PAR DES GROUPES RACISTES

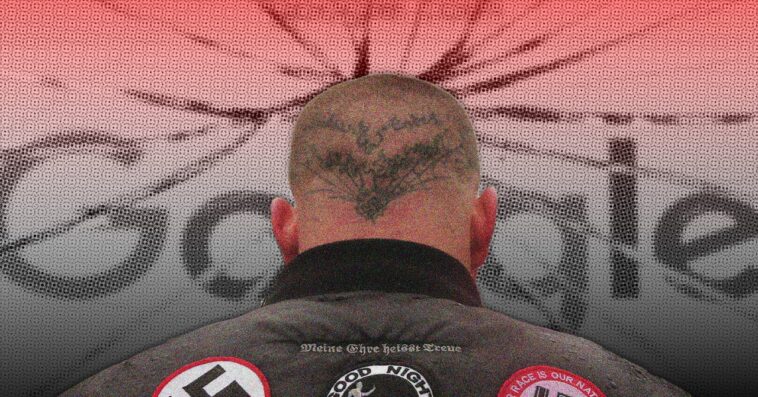

Lynn a publié diverses versions de sa base de données de QI nationaux au fil des décennies, la plus récente étant "L’Intelligence des Nations", publiée en 2019. Au fil des ans, le travail défectueux de Lynn a été utilisé par des groupes d’extrême droite et racistes comme preuve à l’appui des revendications de supériorité blanche. Les données ont également été transformées en une carte du monde codée par couleur, montrant les pays d’Afrique subsaharienne avec des QI présumément faibles en rouge par rapport aux nations occidentales, qui sont en bleu.

RESPONSABILITÉ PARTAGÉE ENTRE LES SYSTÈMES IA ET LA COMMUNAUTÉ SCIENTIFIQUE

Rutherford estime que la culpabilité ne incombe pas seulement aux systèmes IA, mais aussi à une communauté scientifique qui cite depuis des années le travail de Lynn de manière inconditionnelle. Il souligne que le travail de Lynn sur le QI a été accepté assez sans discernement dans une grande partie du monde universitaire, et que le nombre de fois où ses bases de données de QI nationaux ont été citées dans des travaux académiques se compte par centaines. Ainsi, la faute ne revient pas à l’IA, mais à l’académie.

Pour en savoir plus sur ce sujet, consultez les études et prépublications suivantes :

- L’article sur les travaux de Lynn : Lien vers l’article

- Étude préliminaire de 2020 sur le biais des échantillons : Lien vers l’étude